Cómo conectar a un servidor vía FTP desde SUSE Linux Enterprise Server 15 o superior.

Hoy he tenido que conectar hacia un servidor usando FTP, ya que en el otro lado no quieren usar SFTP. Cuál ha sido mi sorpresa que al tratar de realizar la conexión como he hecho toda la vida, es decir:

El comando ftp me ha devuelto:

Al usar SUSE Linux Enterprise Server 15, he ido a software.opensuse.org para buscar el binario 'ftp', pero no he encontrado el paquete. Tras darle vueltas al asunto, me he decantado por instalar lftp para poder conectar a un servidor remoto usando el protocolo ftp, ya que el programa lftp permite usar múltiples protocolos para iniciar una conexión (FTP, FTPS, HTTP, HTTPS, FISH, SFTP...).

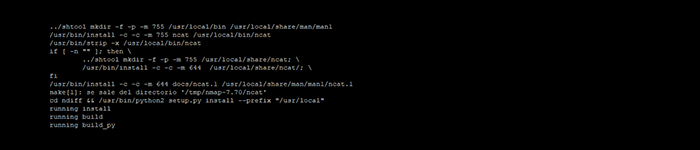

He instalado lftp con zypper:

Tras instalar lftp, he ejecutado el comando 'ftp' y he visto lo siguiente:

Es decir, una vez instalado, lftp actúa como wrapper al usar el comando ftp.

Visto esto, me he conectado al servidor como he venido haciendo toda la vida:

Listo, ya podemos volver a usar el comando ftp desde la terminal o ejecutarlo de forma desatendida dentro de nuestros scripts al usar un SUSE Linux Enterprise Server 15 o superior.

Hoy he tenido que conectar hacia un servidor usando FTP, ya que en el otro lado no quieren usar SFTP. Cuál ha sido mi sorpresa que al tratar de realizar la conexión como he hecho toda la vida, es decir:

HOST# ftp 192.168.1.1

El comando ftp me ha devuelto:

If 'ftp' is not a typo you can use command-not-found to lookup the package that contains it, like this:

cnf ftp

Al usar SUSE Linux Enterprise Server 15, he ido a software.opensuse.org para buscar el binario 'ftp', pero no he encontrado el paquete. Tras darle vueltas al asunto, me he decantado por instalar lftp para poder conectar a un servidor remoto usando el protocolo ftp, ya que el programa lftp permite usar múltiples protocolos para iniciar una conexión (FTP, FTPS, HTTP, HTTPS, FISH, SFTP...).

He instalado lftp con zypper:

HOST# zypper install lftp

Tras instalar lftp, he ejecutado el comando 'ftp' y he visto lo siguiente:

HOST# ftp

Wrapper for lftp to simulate compatibility with lukemftp

lftp :~>

Es decir, una vez instalado, lftp actúa como wrapper al usar el comando ftp.

Visto esto, me he conectado al servidor como he venido haciendo toda la vida:

HOST# ftp 192.168.1.1

Wrapper for lftp to simulate compatibility with lukemftp

Name (root): user

Password:

lftp user@192.168.1.1:~>

Listo, ya podemos volver a usar el comando ftp desde la terminal o ejecutarlo de forma desatendida dentro de nuestros scripts al usar un SUSE Linux Enterprise Server 15 o superior.