Cómo instalar un Service Pack en un SUSE Linux Enterprise Server 12.

Hace unos días, SUSE lanzó el Service Pack 4 para SUSE Linux Enterprise 12. Este Service Pack dota a SLES 12 de soporte para nuevo hardware, instala una nueva versión del kernel, ofrece mejoras de virtualización, etc. además de ser un compendio de todos los parches aparecidos en el lapso de tiempo comprendido entre el SP3 y el SP4.

Para actualizar a este Service Pack, debemos tener, primero de todo, una suscripción activa a SUSE.

Para actualizar a SP4, podemos actualizar desde cualquier versión de SLES 12, desde la versión base hasta la versión SP3. En este artículo, mostraré como actualizar desde SLES 12 versión base a SLES 12 SP4 vía línea de comandos. Hay que decir que es posible actualizar también desde otras vías, como son la ISO del DVD y el entorno gráfico (mediante YasT2).

Primero de todo, sería recomendable ver qué versión de SUSE Linux Enterprise Server tenemos instalada. Lo podemos averiguar de varias formas. Yo he elegido la siguiente:

Vemos que el sistema es un SLES 12 base (base = sin ningún Service Pack instalado).

En este punto, lo ideal es realizar una actualización estándar de paquetes del sistema. Así, si las herramientas de conexión a los repositorios de SUSE hubieran sido actualizadas, podríamos descargar sus últimas versiones y usarlas en la actualización de Service Pack:

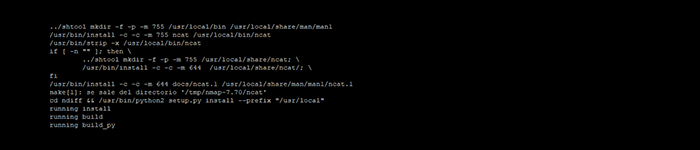

Una vez actualizados los paquetes correspondientes del sistema, ya podemos lanzar la migración hacia el último Service Pack. Como partimos de un SLES 12 base, deberemos instalar primero el Service Pack 3 antes de poder instalar el Service Pack 4:

Elegimos la opción 1 (actualizar a Service Pack 3), aceptamos el acuerdo de licencia y esperamos pacientemente a que se instalen las más de 1.000 actualizaciones.

Cuando el proceso haya terminado, verificamos que se haya instalado el servce Pack 3:

Reiniciamos la máquina. Cuando levante, ya podemos actualizar a Service Pack 4:

Para acabar, verificamos que el Service Pack 4 haya quedado instalado:

Y ya tenemos el SUSE Linux Enterprise Server actualizado a Service Pack 4.

Hace unos días, SUSE lanzó el Service Pack 4 para SUSE Linux Enterprise 12. Este Service Pack dota a SLES 12 de soporte para nuevo hardware, instala una nueva versión del kernel, ofrece mejoras de virtualización, etc. además de ser un compendio de todos los parches aparecidos en el lapso de tiempo comprendido entre el SP3 y el SP4.

Para actualizar a este Service Pack, debemos tener, primero de todo, una suscripción activa a SUSE.

Para actualizar a SP4, podemos actualizar desde cualquier versión de SLES 12, desde la versión base hasta la versión SP3. En este artículo, mostraré como actualizar desde SLES 12 versión base a SLES 12 SP4 vía línea de comandos. Hay que decir que es posible actualizar también desde otras vías, como son la ISO del DVD y el entorno gráfico (mediante YasT2).

Primero de todo, sería recomendable ver qué versión de SUSE Linux Enterprise Server tenemos instalada. Lo podemos averiguar de varias formas. Yo he elegido la siguiente:

HOST# cat /etc/os-release

NAME="SLES"

VERSION="12"

VERSION_ID="12"

PRETTY_NAME="SUSE Linux Enterprise Server 12"

ID="sles"

ANSI_COLOR="0;32"

CPE_NAME="cpe:/o:suse:sles:12"

Vemos que el sistema es un SLES 12 base (base = sin ningún Service Pack instalado).

En este punto, lo ideal es realizar una actualización estándar de paquetes del sistema. Así, si las herramientas de conexión a los repositorios de SUSE hubieran sido actualizadas, podríamos descargar sus últimas versiones y usarlas en la actualización de Service Pack:

HOST# zypper up

Building repository 'SLES12-Pool' cache ...............................[done]

Retrieving repository 'SLES12-Updates' metadata .......................[done]

Building repository 'SLES12-Updates' cache ............................[done]

Loading repository data...

Reading installed packages...

...

Una vez actualizados los paquetes correspondientes del sistema, ya podemos lanzar la migración hacia el último Service Pack. Como partimos de un SLES 12 base, deberemos instalar primero el Service Pack 3 antes de poder instalar el Service Pack 4:

HOST# zypper migration

Executing 'zypper refresh'

Repository 'SLES12-Pool' is up to date.

Repository 'SLES12-Updates' is up to date.

All repositories have been refreshed.

Executing 'zypper --no-refresh patch-check --updatestack-only'

Loading repository data...

Reading installed packages...

0 patches needed (0 security patches)

Available migrations:

1 | SUSE Linux Enterprise Server 12 SP3 x86_64

2 | SUSE Linux Enterprise Server 12 SP2 x86_64

3 | SUSE Linux Enterprise Server 12 SP1 x86_64

[num/q]:

Elegimos la opción 1 (actualizar a Service Pack 3), aceptamos el acuerdo de licencia y esperamos pacientemente a que se instalen las más de 1.000 actualizaciones.

Cuando el proceso haya terminado, verificamos que se haya instalado el servce Pack 3:

HOST# cat /etc/os-release

NAME="SLES"

VERSION="12-SP3"

VERSION_ID="12.3"

PRETTY_NAME="SUSE Linux Enterprise Server 12 SP3"

ID="sles"

ANSI_COLOR="0;32"

CPE_NAME="cpe:/o:suse:sles:12:sp3"

Reiniciamos la máquina. Cuando levante, ya podemos actualizar a Service Pack 4:

HOST# zypper migration

Executing 'zypper refresh'

Repository 'SLES12-SP3-Pool' is up to date.

Repository 'SLES12-SP3-Updates' is up to date.

All repositories have been refreshed.

Executing 'zypper --no-refresh patch-check --updatestack-only'

Loading repository data...

Reading installed packages...

Considering 0 out of 0 applicable patches:

0 patches needed (0 security patches)

Available migrations:

1 | SUSE Linux Enterprise Server 12 SP4 x86_64

[num/q]:

Para acabar, verificamos que el Service Pack 4 haya quedado instalado:

HOST# cat /etc/os-release

NAME="SLES"

VERSION="12-SP4"

VERSION_ID="12.4"

PRETTY_NAME="SUSE Linux Enterprise Server 12 SP4"

ID="sles"

ANSI_COLOR="0;32"

CPE_NAME="cpe:/o:suse:sles:12:sp4"

Y ya tenemos el SUSE Linux Enterprise Server actualizado a Service Pack 4.