Pasos a seguir para conectarse por SSH a una instancia EC2 Linux en Amazon Web Services (AWS).

Al igual que ocurre al desplegar una instancia Windows en Amazon Web Services, al desplegar una instancia Linux en AWS se debe generar un par de claves pública/privada, que luego nos servirán para acceder a la instancia. A continuación, se debe descargar la clave privada (fichero.pem), la cual actuará como "contraseña" para acceder al sistema operativo.

Con el usuario, la IP de la instancia y la clave privada, podremos conectarnos por SSH a la máquina que hayamos desplegado. El usuario para conectarse a una instancia varia según la distribución Linux.

La lista de usuarios y distribuciones soportadas es la siguiente:

Para Amazon Linux, el nombre de usuario es ec2-user.

Para CentOS, el nombre de usuario es centos.

Para Debian, el nombre de usuario es admin o root.

Para Fedora, el nombre de usuario es ec2-user o fedora.

Para RHEL, el nombre de usuario es ec2-user o root.

Para SUSE, el nombre de usuario es ec2-user o root.

Para Ubuntu, el nombre de usuario es ubuntu.

Para conectarse a una instancia Linux mediante SSH desde un sistema operativo Linux, hay que especificar el archivo de clave privada (.pem), el usuario y la IP de la instancia. Por ejemplo:

Para conectarse con PuTTY a una instancia Linux en AWS, primero hay que convertir la clave privada de la instancia mediante PuTTYgen, ya que PuTTY no admite de forma nativa claves en formato .pem. PuTTY tiene la herramienta PuTTYgen que permite convertir claves al formato que usa PuTTY (.ppk).

Para convertir la clave privada, abrir PuTTYgen y en "Type of key to generate", elegir RSA.

Clicar "Load" para cargar el fichero .pem. Recordar que hay que seleccionar la opción de mostrar todos los tipos de archivo para ver los archivos .pem.

Una vez cargado el fichero .pem, elegir "Save private key" (Guardar clave privada) para guardar la clave en un formato que PuTTY pueda usar. PuTTYgen mostrará una advertencia acerca de guardar la clave sin contraseña. Si se elije "Yes" se guardará la clave privada sin contraseña.

Opcionalmente, podemos usar una contraseña en la clave privada. Esto actúa como una capa adicional de seguridad. De esta forma, si alguien consigue robarnos la clave privada, no la podrá usar sin la contraseña. El inconveniente de usar una contraseña en una clave privada es que dificulta la automatización de tareas, puesto que la intervención humana es necesaria para, por ejemplo, iniciar sesión en una instancia.

La clave privada está ahora en el formato correcto para su uso con PuTTY.

Para conectarse a la instancia Linux mediante PuTTY, hay que insertar el nombre de usuario y la IP de la instancia en el campo "Host Name" del apartado Session, por ejemplo, ec2-user@10.1.12.34.

Comentar que se puede configurar PuTTY para que envíe datos "keepalive" a intervalos regulares para mantener la sesión activa. Esto es útil para evitar desconectarse de una instancia por inactividad. En el panel Category, elegir Connection y escribir el intervalo deseado en "Seconds between keepalives".

Para especificar la clave privada, abrir Connection, abrir SSH y elegir Auth (Autenticación).

Elegir Browse y seleccionar el archivo .ppk que se ha generado anteriormente.

Si se va a iniciar sesión frecuentemente en esta instancia, se puede guardar la sesión en la sección "Terminal" para usarla en el futuro. Para ello, elegir un nombre de sesión y clicar el botón Save.

Ahora ya se puede clicar Open para abrir una conexión SSH hacia la instancia.

NOTA: si se ha especificado una contraseña al convertir la clave privada al formato de PuTTY, se deberá introducir la contraseña en este momento.

Fuentes:

https://docs.aws.amazon.com/es_es/AWSEC2/latest/UserGuide/AccessingInstancesLinux.html

https://docs.aws.amazon.com/es_es/AWSEC2/latest/UserGuide/putty.html

Al igual que ocurre al desplegar una instancia Windows en Amazon Web Services, al desplegar una instancia Linux en AWS se debe generar un par de claves pública/privada, que luego nos servirán para acceder a la instancia. A continuación, se debe descargar la clave privada (fichero.pem), la cual actuará como "contraseña" para acceder al sistema operativo.

Con el usuario, la IP de la instancia y la clave privada, podremos conectarnos por SSH a la máquina que hayamos desplegado. El usuario para conectarse a una instancia varia según la distribución Linux.

La lista de usuarios y distribuciones soportadas es la siguiente:

Para Amazon Linux, el nombre de usuario es ec2-user.

Para CentOS, el nombre de usuario es centos.

Para Debian, el nombre de usuario es admin o root.

Para Fedora, el nombre de usuario es ec2-user o fedora.

Para RHEL, el nombre de usuario es ec2-user o root.

Para SUSE, el nombre de usuario es ec2-user o root.

Para Ubuntu, el nombre de usuario es ubuntu.

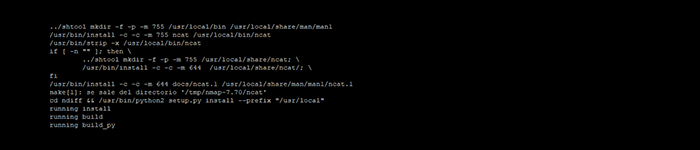

Conectarse desde Linux

Para conectarse a una instancia Linux mediante SSH desde un sistema operativo Linux, hay que especificar el archivo de clave privada (.pem), el usuario y la IP de la instancia. Por ejemplo:

HOST# ssh -i key.pem ec2-user@10.11.25.1

Conectarse desde Windows (PuTTy)

Para conectarse con PuTTY a una instancia Linux en AWS, primero hay que convertir la clave privada de la instancia mediante PuTTYgen, ya que PuTTY no admite de forma nativa claves en formato .pem. PuTTY tiene la herramienta PuTTYgen que permite convertir claves al formato que usa PuTTY (.ppk).

Para convertir la clave privada, abrir PuTTYgen y en "Type of key to generate", elegir RSA.

Clicar "Load" para cargar el fichero .pem. Recordar que hay que seleccionar la opción de mostrar todos los tipos de archivo para ver los archivos .pem.

Una vez cargado el fichero .pem, elegir "Save private key" (Guardar clave privada) para guardar la clave en un formato que PuTTY pueda usar. PuTTYgen mostrará una advertencia acerca de guardar la clave sin contraseña. Si se elije "Yes" se guardará la clave privada sin contraseña.

Opcionalmente, podemos usar una contraseña en la clave privada. Esto actúa como una capa adicional de seguridad. De esta forma, si alguien consigue robarnos la clave privada, no la podrá usar sin la contraseña. El inconveniente de usar una contraseña en una clave privada es que dificulta la automatización de tareas, puesto que la intervención humana es necesaria para, por ejemplo, iniciar sesión en una instancia.

La clave privada está ahora en el formato correcto para su uso con PuTTY.

Para conectarse a la instancia Linux mediante PuTTY, hay que insertar el nombre de usuario y la IP de la instancia en el campo "Host Name" del apartado Session, por ejemplo, ec2-user@10.1.12.34.

Comentar que se puede configurar PuTTY para que envíe datos "keepalive" a intervalos regulares para mantener la sesión activa. Esto es útil para evitar desconectarse de una instancia por inactividad. En el panel Category, elegir Connection y escribir el intervalo deseado en "Seconds between keepalives".

Para especificar la clave privada, abrir Connection, abrir SSH y elegir Auth (Autenticación).

Elegir Browse y seleccionar el archivo .ppk que se ha generado anteriormente.

Si se va a iniciar sesión frecuentemente en esta instancia, se puede guardar la sesión en la sección "Terminal" para usarla en el futuro. Para ello, elegir un nombre de sesión y clicar el botón Save.

Ahora ya se puede clicar Open para abrir una conexión SSH hacia la instancia.

NOTA: si se ha especificado una contraseña al convertir la clave privada al formato de PuTTY, se deberá introducir la contraseña en este momento.

Fuentes:

https://docs.aws.amazon.com/es_es/AWSEC2/latest/UserGuide/AccessingInstancesLinux.html

https://docs.aws.amazon.com/es_es/AWSEC2/latest/UserGuide/putty.html